Faut-il avoir peur des algorithmes?

Cathy O'Neil, devons-nous avoir peur des algorithmes?

Plutôt de leurs effets, car on croit toujours que les algorithmes sont justes et objectifs, mais ce n'est pas le cas.

Vous voulez dire que les algorithmes sont discriminants?

Le Big Data, ce n'est qu'un programme informatique qui évalue des données à une vitesse sidérale, comme par exemple des milliers de cartes de crédit ou de candidatures. Le candidat le plus prometteur arrive en tête de liste, et on qualifie cela de juste et objectif. À tort.

Un algorithme est développé sur la base de nombreuses décisions subjectives, prises par une personne avec tous ses préjugés et malentendus. Un algorithme n’est rien moins qu'un ensemble d'opinions dissimulées dans des codes mathématiques.

Un algorithme n'est rien de moins qu'un ensemble d'opinions dissimulées dans des codes mathématiques.

Même si un programme informatique a été développé avec la meilleure intention, il peut s'avérer dangereux et nuire surtout aux populations les plus fragiles.

Pouvez-vous nous donner un exemple?

Bien sûr. Mon exemple préféré est celui d'un algorithme utilisé pour évaluer des enseignants à Washington, surtout dans les quartiers populaires. L'idée première est bonne, car elle doit permettre d'identifier les mauvais enseignants et, ainsi, d'améliorer l'éducation des petits afro-américains.

L'algorithme mesure les résultats scolaires de l'élève. Mais il est tellement imprécis que les résultats découlant de l'évaluation sont complètement absurdes. L'un des enseignants a par exemple reçu 6 points sur 100 une année, puis 96 points l'année suivante, alors qu'il n'avait rien changé à son mode d'enseignement. Et pourtant, des enseignants ont été et sont toujours licenciés sur la base de cet algorithme.

De bons enseignants ont reçu de mauvaises évaluations à cause de cet algorithme. Ils ont trouvé de nouveaux emplois, certains dans des écoles privées de quartiers plus riches. Au final, les conditions d'enseignement des enfants afro-américains se sont détériorées plutôt qu'améliorées.

Comment aurait-on pu éviter cela?

Un algorithme sain contrôle sans arrêt s'il fait bien ce qu'il doit faire. Prenons par exemple les recommandations de produits sur Amazon. L'algorithme reconnaît quand je ne suis pas intéressée par un produit et me propose un autre produit la prochaine fois. Il apprend.

Dans le cas de l'enseignant, l’algorithme était tellement peu transparent qu'il était impossible de vérifier si les enseignants ayant reçu de mauvaises évaluations étaient réellement de mauvais enseignants. Pire encore: plus on utilisait le système, plus on perdait de bons professeurs.

Que proposez-vous?

Lorsqu'il est question d'algorithmes ayant un impact important sur la vie gens, le processus ayant mené à leur conception doit être dévoilé. Le grand public doit avoir son mot à dire. Mais dans la réalité, c'est tout le contraire, et on entend souvent dire: "C'est des maths, vous ne pouvez pas comprendre.".

Devrait-on alors obliger les entreprises à divulguer leurs algorithmes?

Oui, tout comme les constructeurs automobiles qui sont obligés de soumettre leurs véhicules à un contrôle sécurité.

Les entreprises devraient être obligées de faire vérifier leurs algorithmes, comme les constructeurs automobiles obligés de soumettre leurs véhicules à un contrôle sécurité.

Dans le cas d'algorithmes importants, il faudrait prouver qu'ils sont justes, statistiquement pertinents et qu'ils suivent un cycle de contrôle permettant de vérifier qu'ils fonctionnent bien. Ils ne doivent être ni sexistes, ni racistes et ne léser personne. Et en cas de problème, l'algorithme doit être optimisé.

Une question un peu provocatrice: est-ce que cela me concerne?

Chacun cherche tôt ou tard un job ou a besoin d'un crédit. Et si vous n’êtes pas directement concerné, vos enfants le seront.

De plus, Internet est un parfait outil de propagande. En dressant notre profil sur la base de ce que nous consommons, il dévoile par exemple nos opinions politiques. Ainsi, nous devenons complètement influençables.

Dans votre livre, vous donnez l'exemple de Facebook, où un algorithme décide des news que nous voyons. Notre démocratie est-elle victime de cet algorithme?

Tout à fait. Facebook commence tout juste à passer aux aveux. Son pouvoir a été clairement dévoilé dans le cadre de l'étude sur les élections présidentielles américaines en 2012, où l'on espérait encourager les gens à aller voter en insérant sur le profil de certains un bouton "J'ai voté". L'internaute qui cliquait sur ce bouton montrait à ses amis qu'il avait voté. Effectivement, plus de gens se sont rendus aux urnes.

Ce n'est pas la quantité de données qu'on recueille qui m'inquiète, mais ce qu'on en fait.

Imaginez si, lors de la dernière présidentielle, chaque électeur potentiel avait eu ce bouton à disposition... il y aurait certainement eu plus de votants. Cela aurait pu changer l'issue du vote. Pire encore: Facebook aurait pu n'activer ce bouton que chez les Démocrates!

!["Who Targets Me" analyse comment les partis politiques ciblent les internautes via les publicités Facebook. [AFP - Justin Tallis] "Who Targets Me" analyse comment les partis politiques ciblent les internautes via les publicités Facebook. [AFP - Justin Tallis]](https://img.rts.ch/articles/2017/image/jyw8y2-27781248.image?mw=1280)

Les entreprises recueillent nos données mais nous, de notre côté, on s'en donne à cœur joie. Nous publions ce que nous mangeons, comment nous dormons… et tout ça de notre plein gré. Pensez-vous que nous voulons vraiment que ça change?

Non, nous apprécions tous ces services. Et je suis ok avec ça. Nos données peuvent sans problème être publiées. Ce qui m'inquiète c’est la manière dont ces données sont traitées. Est-ce aux entreprises de décider des messages politiques? De nos emplois? Des cartes de crédit auxquelles on a droit?

Qu'est-ce qui vous a le plus choqué dans lors de vos recherches?

Je retombais toujours sur le même processus: les algorithmes classent les gens par vainqueurs et perdants. Ce sont eux qui décident qui est sélectionné pour le poste, qui est admis à l'université et qui va en prison sans passer par le start.

Ce qui m'a choquée, c’est de réaliser que je faisais partie d'un système qui met en danger la démocratie. Les algorithmes sont intrinsèquement injustes; il faut que ça change. Ce n'est qu'alors qu'ils rendront nos sociétés plus justes.

Corinna Daus/mh/mg

Cet article a été publié sur SRF Kultur.

Cathy O'Neil

Cathy O'Neil est mathématicienne et scientifique des données. Elle a créé l'entreprise ORCAA, qui vérifie l'équité des algorithmes et anime le blog mathbabe. Dans son livre "L'attaque des algorithmes" (titre original: "Armes de destruction matheuses"), elle met en garde contre les dangers du Big Data et du pouvoir des algorithmes.

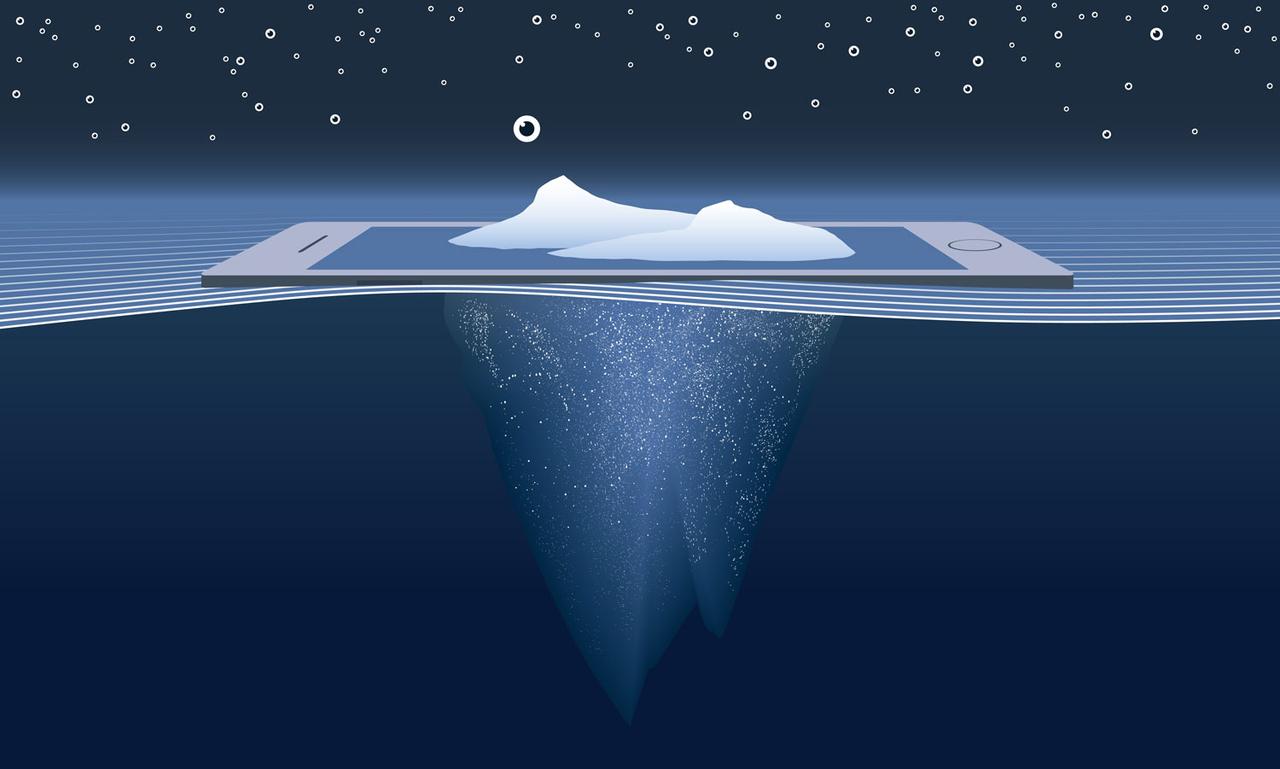

![Faut-il avoir peur des algorithmes? [Fotolia - GianlucaCiroTancredi] Faut-il avoir peur des algorithmes? [Fotolia - GianlucaCiroTancredi]](https://img.rts.ch/articles/2017/image/9bjtz6-27781246.image?w=640&h=360)